Sinumeriker

Neuer Benutzer

- Beiträge

- 3

Hallo Zusammen...

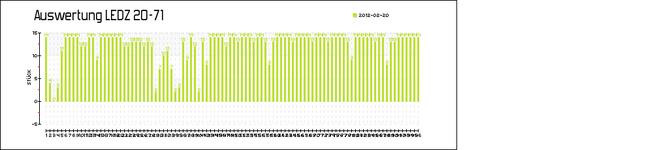

Für eine Maschinendatenerfassung wird bei der Fertigstellung eines Teiles ein neuer Datensatz in einer Datenbank geschrieben (Id, Maschine, Datum + Zeit)

Die Auswertung erfolgt dann in 15 Minuten Schritten.

Eigentlich funktioniert das alles gut.

Problematisch wird die Größe der Datenbank (ca. 20 Millionen Datensätze / Jahr).

Grade die Auswertung dauert viel zu Lange. Ich lasse eine Schleife laufen die für jede 15 Minuten eines Tages eine SQL Abfrage startet was mein PHP / SQL in die Knie zwingt…

Daher war meine Überlegung die Datensätze mittels Update SET count = count + 1

in 15 Minuten Pakete aufzusplitten…

Hierbei stoße ich aber an meine Wissensgrenzen…

Ist mein Ansatz richtig oder gibt es da bessere / einfachere Lösungen?

Grüße aus dem Sauerland…

Peter

Für eine Maschinendatenerfassung wird bei der Fertigstellung eines Teiles ein neuer Datensatz in einer Datenbank geschrieben (Id, Maschine, Datum + Zeit)

Die Auswertung erfolgt dann in 15 Minuten Schritten.

Eigentlich funktioniert das alles gut.

Problematisch wird die Größe der Datenbank (ca. 20 Millionen Datensätze / Jahr).

Grade die Auswertung dauert viel zu Lange. Ich lasse eine Schleife laufen die für jede 15 Minuten eines Tages eine SQL Abfrage startet was mein PHP / SQL in die Knie zwingt…

Daher war meine Überlegung die Datensätze mittels Update SET count = count + 1

in 15 Minuten Pakete aufzusplitten…

Hierbei stoße ich aber an meine Wissensgrenzen…

Ist mein Ansatz richtig oder gibt es da bessere / einfachere Lösungen?

Grüße aus dem Sauerland…

Peter